Bức tranh an ninh mạng toàn cầu đang thay đổi nhanh chóng dưới tác động của trí tuệ nhân tạo thế hệ mới, đặc biệt là AI tạo sinh (generative AI). Những công cụ như mô hình ngôn ngữ lớn (LLMs) đang bị các tác nhân tấn công lợi dụng để giả mạo danh tính và thực hiện các chiến thuật tấn công lừa đảo social engineering với quy mô chưa từng có.

Thực tế này đặt ra một câu hỏi quan trọng: Làm thế nào để ngăn chặn — không chỉ đơn thuần là phát hiện những cuộc tấn công dựa trên deepfake ngày càng tinh vi?

Tấn công Deepfake đang không ngừng gia tăng

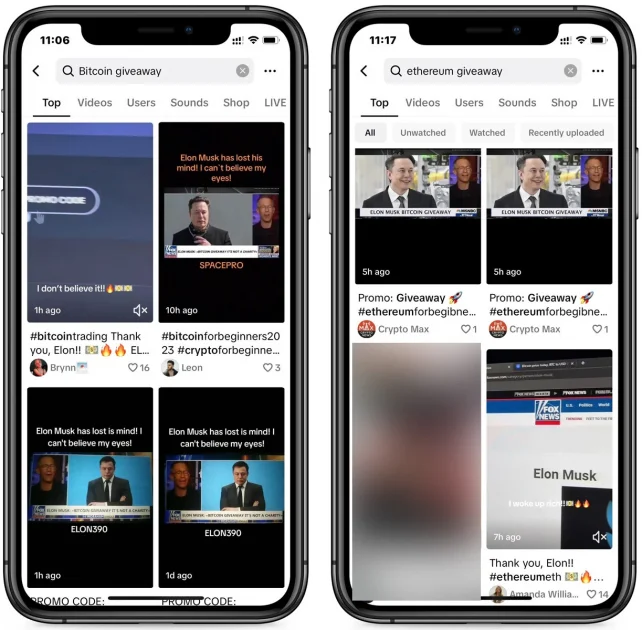

Các báo cáo gần đây đã ghi nhận sự gia tăng đáng kể của các cuộc tấn công sử dụng AI để deepfake giả mạo danh tính. Các chuyên gia VSEC nhận định, sự phát triển của công nghệ deepfake đã khiến tấn công lừa đảo danh tính trở nên dễ dàng hơn bao giờ hết. Bằng cách sử dụng AI để lừa đảo giọng nói và khuôn mặt, kẻ tấn công có thể tạo ra các cuộc gọi âm thanh hoặc video để lừa đảo.

Các biện pháp phòng vệ truyền thống vốn đã gặp khó khăn trong việc ngăn chặn hình thức tấn công deepfake này, và giờ đây, với sự hỗ trợ của trí tuệ nhân tạo, tin tặc có thể thực hiện các cuộc tấn công nhanh hơn, quy mô lớn hơn và tinh vi hơn bao giờ hết.

Theo báo cáo của CrowdStrike năm 2025 ghi nhận số lượng cuộc tấn công voice phishing (lừa đảo qua giọng nói – còn gọi là vishing) đã tăng tới 442% chỉ trong vòng sáu tháng cuối năm 2024. Sự gia tăng này chủ yếu đến từ việc sử dụng AI để tổng hợp giọng nói giả, cho phép kẻ tấn công mô phỏng chính xác giọng nói của người thật và lừa đảo nạn nhân với độ tin cậy cao.

Kẻ tấn công thường đóng giả một nhân vật có uy tín – chẳng hạn như nhân viên ngân hàng, quản lý cấp cao hoặc chuyên gia IT – rồi tạo ra cảm giác cấp bách để buộc nạn nhân hành động ngay lập tức. Các cuộc gọi này có thể yêu cầu chuyển tiền hoặc cung cấp thông tin đăng nhập.

Theo thống kê năm 2022, các nạn nhân trung bình mất khoảng 1.400 USD do các cuộc tấn công này. Đặc biệt, với sự hỗ trợ của trí tuệ nhân tạo, kẻ tấn công có thể sao chép giọng nói của bất kỳ ai chỉ từ vài giây ghi âm. Điều này khiến nạn nhân dễ dàng tin tưởng mà không nghi ngờ.

Không chỉ dừng lại ở vishing, các hình thức tấn công lừa đảo truyền thống như phishing (giả mạo qua email) và pretexting (giả danh nhằm thu thập thông tin nhạy cảm) vẫn chiếm phần lớn trong các sự cố vi phạm bảo mật, theo Báo cáo 2025 Data Breach Investigations Report của Verizon.

Thậm chí, một số nhóm tin tặc có liên hệ với chính phủ Triều Tiên đã bị phát hiện sử dụng deepfake để tạo ra danh tính ảo nhằm vượt qua vòng phỏng vấn xin việc trực tuyến, từ đó thâm nhập vào các tổ chức thông qua mô hình làm việc từ xa.

Theo các chuyên gia VSEC, với sự phát triển vượt bậc của công nghệ trí tuệ nhân tạo, AI tạo sinh đang bị lạm dụng để tạo ra các video deepfake, từ đó thực hiện các hành vi lừa đảo tài chính, tấn công lừa đảo và đánh cắp danh tính. Sự xuất hiện của các video và âm thanh giả mạo siêu thực ngày càng tạo áp lực cho việc xác thực thông tin và làm suy giảm lòng tin vào các hệ thống xác minh truyền thống.

Hạn chế của hệ thống phòng thủ trước các cuộc tấn công bằng AI

Trí tuệ nhân tạo đang mở ra một kỷ nguyên mới cho các chiến dịch tấn công mạng — nơi những kẻ tấn công có thể mạo danh bất kỳ ai một cách dễ dàng và thuyết phục. Chỉ với vài phút dữ liệu giọng nói hoặc hình ảnh, chúng có thể sử dụng các công cụ mã nguồn mở để tạo ra bản sao gần như hoàn hảo của một cá nhân thật, phục vụ cho các cuộc lừa đảo có chủ đích.

Trong khi đó, phần lớn các hệ thống phòng thủ hiện nay vẫn vẫn dựa vào các thuật toán xác suất để đánh giá độ tin cậy, thay vì cung cấp một cơ chế xác thực có thể kiểm chứng, chẳng hạn như nhận diện khuôn mặt, phân tích biểu cảm hoặc hành vi. Những công cụ này chỉ đưa ra khả năng một đối tượng có thể là giả mạo, thay vì cung cấp bằng chứng xác thực.

Công nghệ phát hiện deepfake tuy đã có nhiều tiến bộ, nhưng vẫn chủ yếu dựa vào phân tích hành vi, đặc điểm khuôn mặt hoặc giọng nói để đưa ra nhận định – vốn không đủ chính xác trong những tình huống đòi hỏi mức độ tin cậy tuyệt đối.

Ngay cả khi tổ chức đã triển khai giải pháp bảo mật đầu cuối và đào tạo người dùng nhận diện rủi ro, vẫn tồn tại một khoảng trống lớn: Làm sao để biết người đang tương tác với mình thực sự là ai?

Chủ động giám sát và phát hiện mối nguy

Hầu hết các phương pháp bảo vệ hiện nay tập trung vào việc phát hiện hành vi bất thường sau khi sự cố đã xảy ra và gây thiệt hại. Người dùng được hướng dẫn nhận diện dấu hiệu bất thường, trong khi các hệ thống AI hỗ trợ phân tích để xác định hành vi giả mạo. Tuy nhiên, với sự phát triển nhanh chóng và độ tinh vi ngày càng cao của công nghệ deepfake, các phương pháp trên đang dần trở nên thiếu hiệu quả.

Trong bối cảnh các cuộc tấn công mạng không ngừng gia tăng cả về số lượng và mức độ tinh vi, phức tạp, các chuyên gia VSEC khuyến nghị phương pháp “An ninh mạng chủ động”. Thay vì chỉ phản ứng khi phát hiện tấn công, các hệ thống cần được thiết kế để giám sát liên tục, phát hiện sớm và giảm thiểu rủi ro ngay từ giai đoạn chuẩn bị của đối tượng tấn công.

Các chuyên gia bảo mật cũng đề xuất một số cách tiếp cận hiệu quả đang được nhiều tổ chức, doanh nghiệp áp dụng rộng rãi như: dịch vụ MDR cung cấp khả năng giám sát 24/7, phân tích mối đe dọa nâng cao và phản ứng sự cố nhanh chóng, giúp các tổ chức giảm thiểu thời gian phản hồi và thiệt hại do các cuộc tấn công.

Theo các chuyên gia VSEC, các công cụ AI tạo sinh có thể tăng độ tin cậy của các vụ tấn công deepfake lên mức khiến chúng rất khó phân biệt với thực tế. Vì vậy, việc chuyển đổi sang cách tiếp cận chủ động không chỉ giúp tổ chức gia tăng khả năng phòng thủ chủ động trước các hình thức tấn công tinh vi, mà còn nâng cao khả năng thích ứng nhanh với các mối đe dọa không ngừng biến đổi.