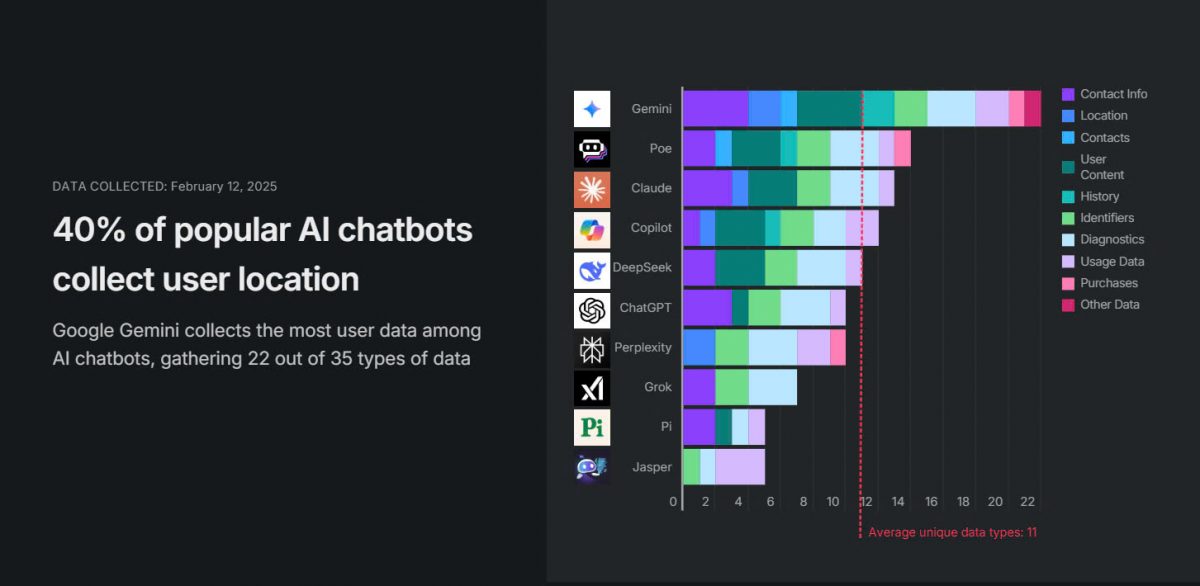

Khi trí tuệ nhân tạo ngày càng trở nên phổ biến, câu hỏi đặt ra không chỉ là những gì AI có thể làm được, mà còn là AI đang thu thập những thông tin gì từ người dùng. Một nghiên cứu mới đây đã phân tích chính sách bảo mật của 10 chatbot AI hàng đầu trên Apple App Store, bao gồm Google Gemini, DeepSeek, ChatGPT và nhiều nền tảng khác. Kết quả cho thấy, mọi chatbot được khảo sát đều thu thập dữ liệu người dùng, nhưng mức độ và phạm vi thu thập có sự khác biệt đáng kể giữa các nền tảng.

Google Gemini dẫn đầu với 22 loại dữ liệu được thu thập, nhiều gần gấp đôi so với mức trung bình là 11 loại. Không chỉ ghi nhận nội dung trò chuyện, Gemini còn thu thập vị trí chính xác, danh bạ liên hệ, lịch sử tìm kiếm, lịch sử duyệt web và nhiều thông tin nhạy cảm khác. Điều đáng nói là Gemini không chỉ lấy dữ liệu từ chính chatbot mà còn tận dụng hệ sinh thái khổng lồ của Google, liên kết với các dịch vụ như Gmail, Google Maps, Google Docs, YouTube để mở rộng khả năng thu thập thông tin cá nhân một cách toàn diện.

Bên cạnh Gemini, DeepSeek cũng thu thập 11 loại dữ liệu, tuy nhiên chính sách bảo mật của nền tảng này cho phép lưu trữ thông tin “khi cần thiết” trên máy chủ đặt tại Trung Quốc. Trước đó, DeepSeek từng gặp sự cố rò rỉ hơn 1 triệu bản ghi trò chuyện, khóa API và dữ liệu nhạy cảm, đặt ra nhiều lo ngại về tính bảo mật. Trong khi đó, ChatGPT thu thập 10 loại dữ liệu nhưng lại cho phép người dùng bật chế độ trò chuyện tạm thời, giúp xóa lịch sử sau 30 ngày, hoặc yêu cầu loại bỏ thông tin cá nhân khỏi tập huấn luyện AI.

Đáng chú ý, 30% các chatbot được nghiên cứu có hành vi chia sẻ dữ liệu người dùng với bên thứ ba nhằm phục vụ quảng cáo hoặc đo lường hiệu quả tiếp thị. Các nền tảng Copilot, Poe và Jasper nằm trong nhóm này, trong đó Jasper thu thập nhiều loại dữ liệu nhất, bao gồm ID thiết bị, dữ liệu quảng cáo và thông tin về cách người dùng tương tác với chatbot. Ngoài ra, Google Gemini, Copilot và Perplexity còn sử dụng địa chỉ IP và tín hiệu Wi-Fi để xác định vị trí chính xác của người dùng.

Sự gia tăng thu thập dữ liệu của các chatbot không chỉ đặt ra câu hỏi về quyền riêng tư mà còn tiềm ẩn nguy cơ dữ liệu cá nhân bị khai thác cho mục đích không mong muốn. Theo các chuyên gia bảo mật, lượng dữ liệu này có thể trở thành mục tiêu hấp dẫn của tội phạm mạng, làm gia tăng nguy cơ rò rỉ và các cuộc tấn công lừa đảo tinh vi. Khi AI ngày càng được tích hợp sâu vào công việc và cuộc sống, việc hiểu rõ cách các chatbot thu thập và xử lý dữ liệu sẽ giúp người dùng chủ động hơn trong việc bảo vệ thông tin cá nhân của mình.

Theo: surfshark, vneconomy