Một bài toán mà doanh nghiệp vẫn chưa tìm ra lời giải thỏa đáng, là làm sao bảo vệ bí mật người dùng trong bối cảnh AI ngày càng được ứng dụng rộng rãi vào hệ thống và hoạt động kinh doanh. Dưới góc độ an ninh mạng, thách thức này chưa thể giải quyết triệt để: doanh nghiệp bị giằng xé giữa việc cân bằng quyền riêng tư – độ chính xác – chi phí, đối diện với nguy cơ model poisoning, khó khăn trong việc chứng minh tính an toàn, và đặc biệt là sự thiếu hụt nguồn nhân lực đáp ứng yêu cầu về chuyên môn lẫn kinh nghiệm.

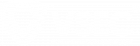

Làm thế nào để máy học mà không làm lộ bí mật người dùng?

Đây là câu hỏi được ông Đặng Việt Hưng, Trưởng phòng Công nghệ Công ty Cổ phần An ninh mạng Việt Nam (VSEC) đặt ra trong workshop hướng nghiệp diễn ra tại Học viện công nghệ Bưu chính viễn thông vào ngày 28/1. Câu hỏi này chạm đến một vấn đề cốt yếu khi ứng dụng AI vào các hệ thống thật: Liệu dữ liệu của người dùng có thực sự an toàn với AI?

AI phát triển nhờ dữ liệu. Chúng được đào tạo từ hàng loạt thông tin như lịch sử truy cập, hành vi duyệt web hay vị trí của người dùng. Những thứ này giúp cho AI học tập và cải thiện thuật toán cá nhân hoá. Tuy nhiên, dưới góc độ an ninh mạng, sự phụ thuộc vào khối lượng dữ liệu khổng lồ dẫn đến một rủi ro lớn: tập trung dữ liệu. Khi thông tin nhạy cảm nằm cùng một nơi, chỉ cần mỗi lỗi cấu hình hay một cuộc tấn công chiếm quyền truy cập, tất cả sẽ bị ảnh hưởng.

Theo ông Đặng Việt Hưng, “Đây không chỉ là bài toán kỹ thuật, mà là bài toán trách nhiệm.” Để bảo vệ bí mật khách hàng mà vẫn phát triển hệ thống, doanh nghiệp cần một phương án mới. Một phương án cho phép AI có thể học tập mà dữ liệu gốc vẫn nằm yên tại nơi nó được hình thành.

Ứng dụng Federated Learning: AI học mà không cần tập trung dữ liệu về một nơi

Federated Learning (FL) là phương pháp cho phép đào tạo AI mà không cần tác động vào thông tin của khách hàng. Nói cách khác, mô hình là thứ di chuyển, còn dữ liệu vẫn nằm nguyên trong máy chủ cục bộ, nơi nó được hình thành. Kỹ thuật FL giúp doanh nghiệp vẫn có thể huấn luyện AI mà không cần chia sẻ log nhạy cảm, không vi phạm chính sách dữ liệu và giảm nhiều rủi ro pháp lý.

Trong thực tế, FL đã được ứng dụng trong nhiều lĩnh vực. Trong ngành y tế, FL giúp máy học kho dữ liệu y tế, đồng thời bảo vệ quyền riêng tư của bệnh nhân, góp phần vào việc cải thiện hệ thống chăm sóc sức khỏe, phát hiện và điều trị các căn bệnh phức tạp. Trong lĩnh vực công nghệ, Google đã ứng dụng FL trong việc phát triển Gboard – bàn phím có khả năng gợi ý từ tiếp theo cho người dùng.

Thế nhưng, Federated Learning không phải là giải pháp hoàn hảo. Nếu thiết kế FL sai, dữ liệu nhạy cảm vẫn có nguy cơ bị lộ lọt. Bên cạnh đó, phương pháp này còn đối diện với rủi ro model poisoning, khi mà mô hình chung bị đầu độc bởi một số khách hàng độc hại, khiến kết quả bị thiên lệch hoặc hướng đến mục đích xấu.

Vì vậy, để đảm bảo an ninh thông tin, FL cần có kiến trúc đủ an toàn. Trong các hệ thống thực tế, FL thường được kết hợp với Secure Aggregation nhằm giúp server chỉ thấy kết quả tổng hợp thay vì truy cập vào dữ liệu thô của người dùng; hoặc Differential Privacy – phương pháp bảo vệ thông tin cá nhân thông qua việc thêm nhiễu vào dữ liệu, gây khó khăn cho kẻ tấn công trong quá trình giải mã.

Những công nghệ này góp phần giúp thiết kế của FL trở nên an toàn hơn. Tuy nhiên, dưới góc độ an ninh mạng, vấn đề đặt ra khi kết hợp giữa FL và bảo mật vẫn chưa thể giải quyết dứt điểm.

Bài toán cân bằng giữa quyền riêng tư – độ chính xác – kinh phí chưa có lời giải tối ưu, đặc biệt là trong lĩnh vực sản xuất. Bởi lẽ, một khi tăng tính bảo mật, doanh nghiệp phải chấp nhận đánh đổi bằng độ chính xác hoặc chi phí đầu tư. Bên cạnh đó, việc phát hiện và đối phó với model poisoning vẫn là một thách thức lớn. Trong trường hợp hệ thống đủ khả năng bảo vệ dữ liệu, doanh nghiệp lại đối mặt với vấn đề thuyết phục khách hàng. Việc này đòi hỏi những tiêu chí đánh giá cụ thể cùng quá trình đo lường, kiểm toán để có thể chứng minh tính an toàn. Và đặc biệt, hiện nay, nguồn nhân lực am hiểu cả hai lĩnh vực AI và an ninh thông tin hãy còn hạn chế.

Cơ hội nghề nghiệp cho thế hệ mới

Thị trường đang đứng trước thách thức về việc ứng dụng AI trong khi vẫn đảm bảo an thông thông tin cho người dùng. Tuy nhiên, chính thách thức này lại mở ra cơ hội cho thế hệ sinh viên trẻ.

Theo dự đoán của ông Đặng Việt Hưng, vào 5-10 năm tới đây, nhu cầu tuyển dụng chuyên gia hiểu AI trong bối cảnh an toàn và trách nhiệm sẽ tăng cao, với đa dạng các vị trí như AI Security Engineer, Privacy Engineer hay ML Engineer thuộc mảng bảo mật.

Với hơn 22 năm kinh nghiệm làm về lĩnh vực an toàn thông tin, VSEC đã đồng hành cùng hàng ngàn doanh nghiệp và tổ chức trong quá trình bảo mật dữ liệu và ứng phó với tội phạm mạng. VSEC đem đến cho sinh viên nhiều cơ hội phát triển kỹ năng thông qua hoạt động tài trợ sân chơi công nghệ – bảo mật, tổ chức hội thảo hướng nghiệp và chương trình tuyển dụng thường xuyên.

Làm việc tại VSEC tạo cho sinh viên cơ hội giao lưu, hợp tác với đội ngũ chuyên gia giàu kinh nghiệm, đồng thời được tiếp cận với công nghệ tiên tiến đến từ các nhà cung cấp hàng đầu thế giới như Trellix hay Palo Alto. Điều này giúp các bạn trẻ vừa củng cố kiến thức chuyên môn, vừa học cách giải quyết các bài toán thực tế của khách hàng.

Với xu thế tích hợp AI vào hệ thống của doanh nghiệp, ưu tiên hàng đầu lúc này là xây dựng cấu trúc đủ an toàn, đảm bảo đúng trách nhiệm pháp lý và tránh tối đa mọi rủi ro cho người dùng. Thế hệ sinh viên hôm nay mang trên vai trách nhiệm tạo dựng những mô hình như vậy trong tương lai.

Và VSEC luôn sẵn sàng đồng hành cùng thế hệ trẻ trong hành trình ấy.

Workshop “Làm sao để máy học mà không làm lộ bí mật người dùng” nằm trong khuôn khổ Cuộc thi Sinh viên An ninh mạng 2025, quy tụ hàng nghìn sinh viên đến từ các nước ASEAN và Nhật Bản. Cuộc thi do Hiệp hội An ninh mạng quốc gia chủ trì tổ chức và VSEC đồng hành tài trợ.